apache

sql

WS2812 5050 RGB

论文阅读

夺旗赛

课程设计

激活函数

漏洞

位置式PID

Cartographer

遥感数据处理

ROBOGUIDE

svn

skill 命令

跨境电商

多任务学习

IDEA 常用插件

kaggle

华为上机考试真题

改进粒子群优化算法

本地部署

2024/4/12 9:56:15Atlassian Server用户新选择 | 云版和本地部署的数据中心版,总有一个适合您

Atlassian对Server版本产品的支持将于2024年2月15日结束,现在,是时候创建您的迁移计划了。一起来看看您需要了解什么基础知识以及如何规划下一步行动吧。

虽然离终止支持还有几个月的时间,但对于使用Server版的企业来说,这是一则…

【linux 使用ollama部署运行本地大模型完整的教程,openai接口, llama2例子】

# 安装相应的包

# linux 安装curl -fsSL https://ollama.com/install.sh | shpip install ollama

# 开启ollama服务端!

$ ollama serve

# 启动llama2大模型(新开一个终端)

# autodl开启加速(其他平台省略)

$ sour…

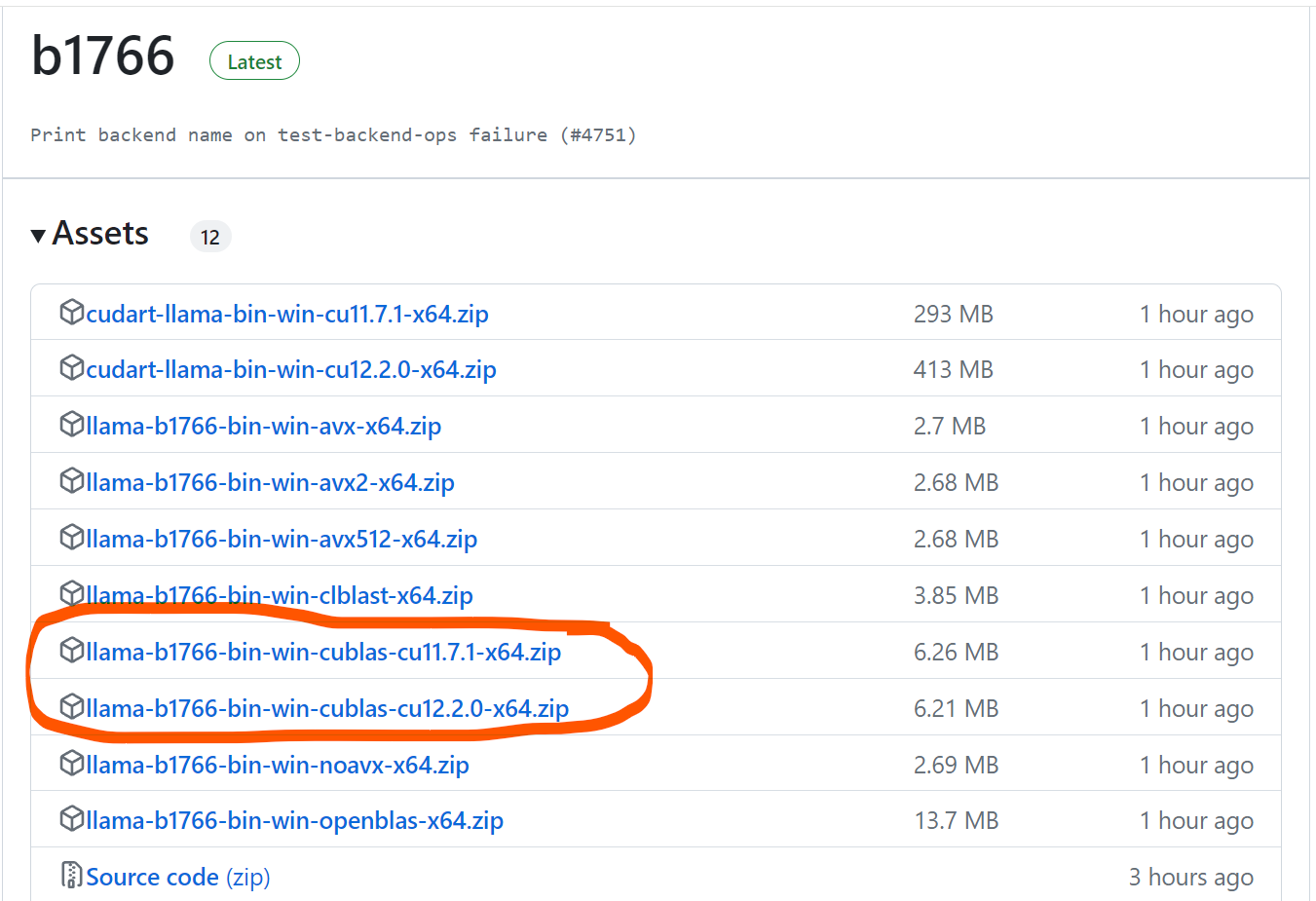

2024-01-04 用llama.cpp部署本地llama2-7b大模型

点击 <C 语言编程核心突破> 快速C语言入门 用llama.cpp部署本地llama2-7b大模型 前言一、下载llama.cpp以及llama2-7B模型文件二、具体调用总结 使用协议: License to use Creative Commons Zero - CC0 该图片个人及商用免费,无需显示归属,但如果…

最强开源Text2SQL大模型本地部署的解决方案

大家好,我是herosunly。985院校硕士毕业,现担任算法研究员一职,热衷于机器学习算法研究与应用。曾获得阿里云天池比赛第一名,CCF比赛第二名,科大讯飞比赛第三名。拥有多项发明专利。对机器学习和深度学习拥有自己独到的见解。曾经辅导过若干个非计算机专业的学生进入到算法…

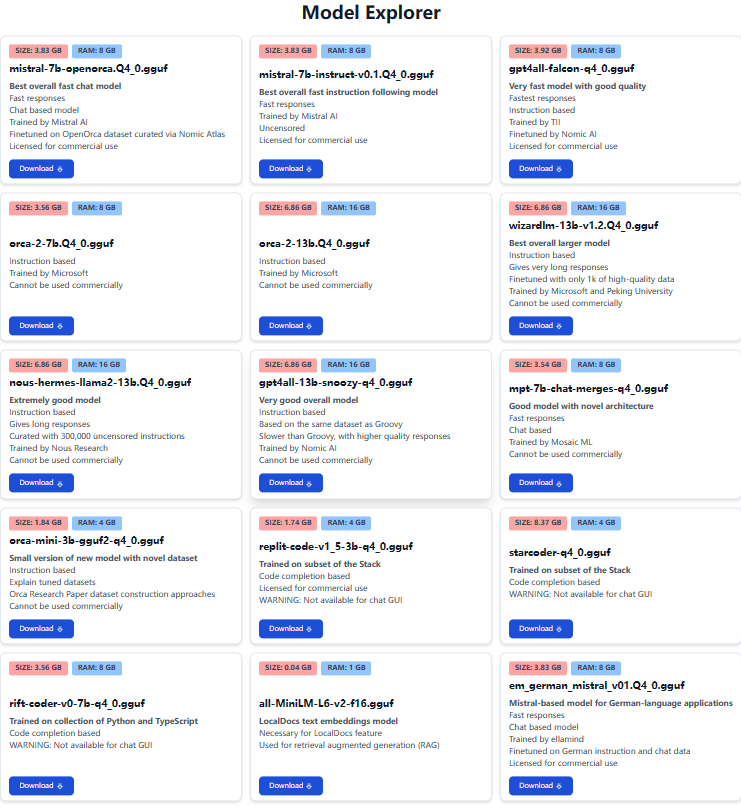

GPT4All 本地部署教程

省流:偷懒的可以直接看第二章的GPT4All部署

一. GPT4All README

根据官方网站GPT4All的描述,它是一个开源大型语言模型,可在CPU和几乎任何GPU上本地运行

github source: https://github.com/nomic-ai/gpt4all

GPT4All Website and Models…

GPT实战系列-实战Qwen在Cuda 12+24G部署方案

GPT实战系列-实战Qwen在Cuda1224G部署方案

ChatGLM4进行新闻发布,但还没有开源更新,在此之际,实战部署测试Qwen大模型。目前Qwen的口碑貌似还不错,测试显卡内存24G,毕竟有限,排除了Qwen14非量化方案Qwen-1…

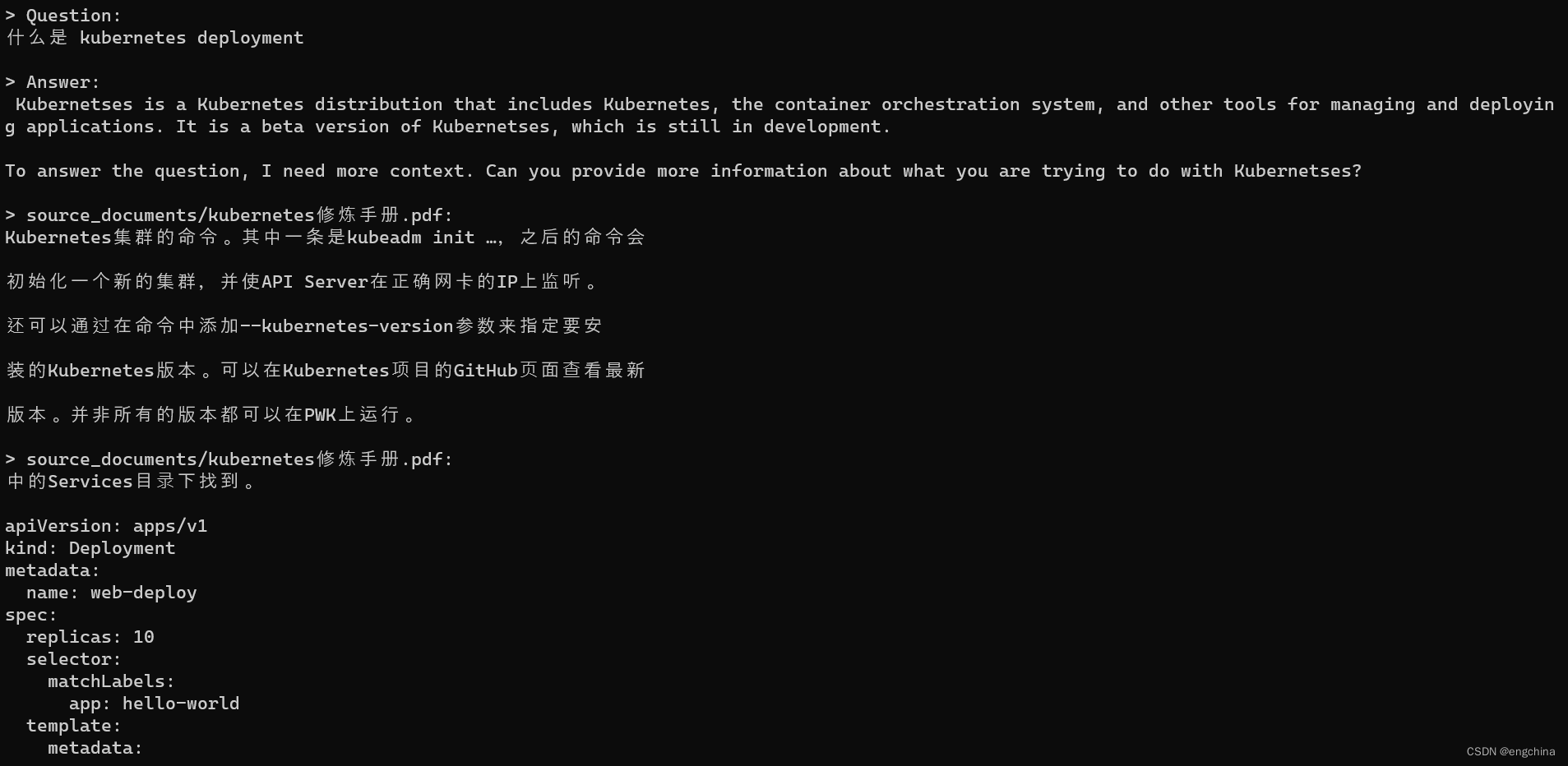

本地部署 privateGPT

本地部署 privateGPT 1. 什么是 privateGPT2. Github 地址3. 创建虚拟环境4. 部署 privateGPT5. 配置 .env6. 下载模型7. 将文件放入 source_documents 目录中8. 摄取所有数据9. 向本地文档提问 1. 什么是 privateGPT

利用 GPT 的强大功能,私密地与您的文档交互&am…

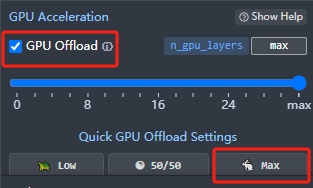

好用且简单的本地大模型聊天工具LM Studio

先看效果: LM Studio是我目前见到最好用,也是最简单的本地测试AI模型的工具,不需要安装python环境以及众多的组件,加载模型、启用GPU、聊天都非常简单。而且可以切换很多不同类型的大语言模型,同时支持在Windows和MA…

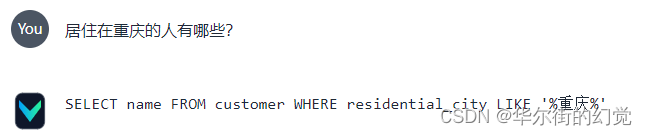

Text-to-SQL 工具Vanna + MySQL本地部署 | 数据库对话机器人

今天我们来重点研究与实测一个开源的Text2SQL优化框架 – Vanna 1. Vanna 简介【Text-to-SQL 工具】

Vanna 是一个基于 MIT 许可的开源 Python RAG(检索增强生成)框架,用于 SQL 生成和相关功能。它允许用户在数据上训练一个 RAG “模型”&a…

GPT实战系列-LangChain + ChatGLM3构建天气查询助手

GPT实战系列-LangChain ChatGLM3构建天气查询助手

用ChatGLM的工具可以实现很多查询接口和执行命令,而LangChain是很热的大模型应用框架。如何联合它们实现大模型查询助手功能?例如调用工具实现网络天气查询助手功能。 LLM大模型相关文章: …

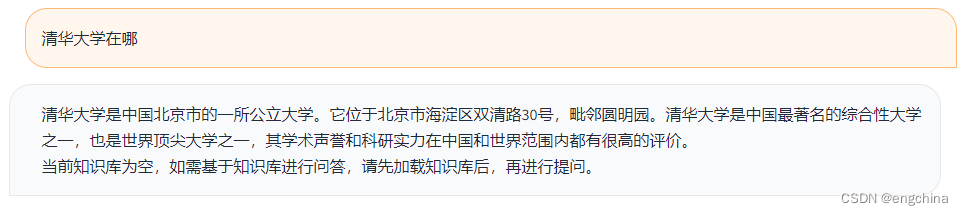

体验 langchain-ChatGLM

体验 langchain-ChatGLM 1. 什么是 langchain-ChatGLM2. 什么是 langchain3. Github 地址4. 安装 Miniconda35. 创建虚拟环境6. 部署 langchain-ChatGLM7. 启动 langchain-ChatGLM8. 访问 langchain-ChatGLM9. API部署10. 命令行部署11. 其他,LangChain Document Lo…

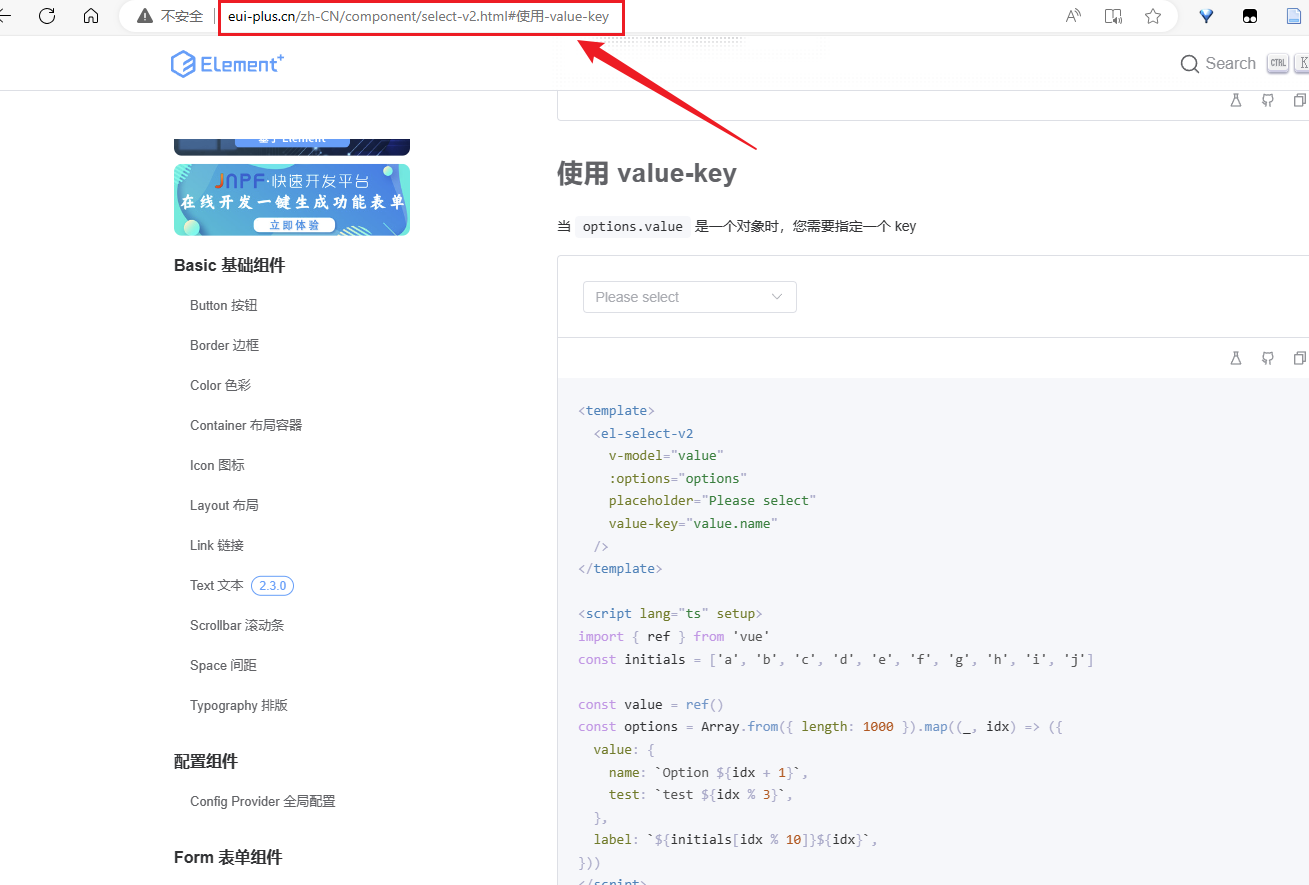

本地部署Element-Plus开发文档

访问Element-Plus文档官网的时候,时不时会很卡,直接卡死 https://element-plus.gitee.io/zh-CN/ 有点影响 CV 大法的施展,看了一下又是 gitee.io ,而且开源的项目,找到文档搞下来本地部署就不用担心卡不卡的问题了 文章…

Orion-14B-Chat-Plugin本地部署的解决方案

大家好,我是herosunly。985院校硕士毕业,现担任算法研究员一职,热衷于机器学习算法研究与应用。曾获得阿里云天池比赛第一名,CCF比赛第二名,科大讯飞比赛第三名。拥有多项发明专利。对机器学习和深度学习拥有自己独到的见解。曾经辅导过若干个非计算机专业的学生进入到算法…

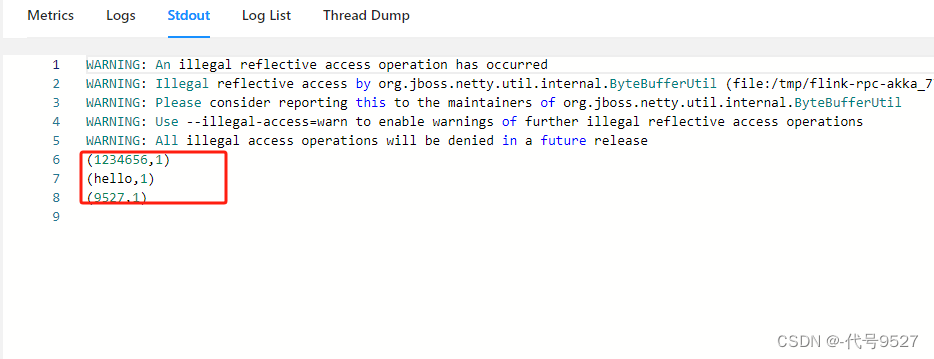

【基础篇】四、本地部署Flink

文章目录 1、本地独立部署会话模式的Flink2、本地独立部署会话模式的Flink集群3、向Flink集群提交作业4、Standalone方式部署单作业模式5、Standalone方式部署应用模式的Flink Flink的常见三种部署方式:

独立部署(Standalone部署)基于K8S部署…

本地部署 Qwen-Audio-Chat

本地部署 Qwen-Audio-Chat Qwen-Audio-Chat 介绍Qwen-Audio Github 地址部署 Qwen-Audio-Chat安装 ffmpeg克隆代码库创建虚拟环境使用 pip 安装 pytorch使用 pip 安装依赖使用 ModelScope运行 Web UIQwen-Audio-Chat 介绍

Qwen-Audio-Chat是通用语音多模态大规模语言模型,因此…

GLM-130B本地部署的实战方案

大家好,我是herosunly。985院校硕士毕业,现担任算法研究员一职,热衷于机器学习算法研究与应用。曾获得阿里云天池比赛第一名,CCF比赛第二名,科大讯飞比赛第三名。拥有多项发明专利。对机器学习和深度学习拥有自己独到的见解。曾经辅导过若干个非计算机专业的学生进入到算法…

GPT实战系列-ChatGLM2部署Ubuntu+Cuda11+显存24G实战方案

GPT实战系列-ChatGLM2部署UbuntuCuda11显存24G实战方案

自从chatGPT掀起的AI大模型热潮以来,国内大模型研究和开源活动,进展也如火如荼。模型越来越大,如何在小显存部署和使用大模型?

本实战专栏将评估一系列的开源模型…

体验 nanoGPT

体验 nanoGPT 1. 使用预训练模型2. 训练自己的模型2-1. 准备训练数据2-2. 模型训练2-3. 模型验证 1. 使用预训练模型

在我们尝试训练自己的模型之前,我们先使用其他人训练好的模型,看看如何在自己的环境中运行聊天机器人。

今天我们使用 GPT4ALL 并从 …